Trong các bài test của tiêu chuẩn ngành về đào tạo AI, GPU NVIDIA H100 Tensor Core đã lập kỷ lục thế giới về tải xử lý doanh nghiệp; Và với A100, đã nâng cấp độ trong điện toán hiệu suất cao.

Hai tháng sau lần đầu tiên đưa ra các điểm chuẩn suy luận MLPerf gây tiếng vang trên lĩnh vực AI, GPU NVIDIA H100 Tensor Core đã lập kỷ lục thế giới về tải xử lý AI của doanh nghiệp trong các thử nghiệm đào tạo AI mới nhất của ngành.

Kết quả cho thấy H100 là lựa chọn tốt nhất cho những người dùng yêu cầu hiệu suất cao nhất khi tạo và triển khai các mô hình AI tiên tiến.

MLPerf là tiêu chuẩn công nghiệp để đo lường hiệu suất của AI. Nó được hỗ trợ bởi một nhóm đông đảo các hãng công nghệ bao gồm Amazon, Arm, Baidu, Google, Đại học Harvard, Intel, Meta, Microsoft, Đại học Stanford và Đại học Toronto.

Trong một điểm chuẩn MLPerf liên quan vừa được công bố, GPU NVIDIA A100 Tensor Core đã nâng mức tiêu chuẩn mà họ đặt ra vào năm ngoái trong điện toán hiệu suất cao (HPC).

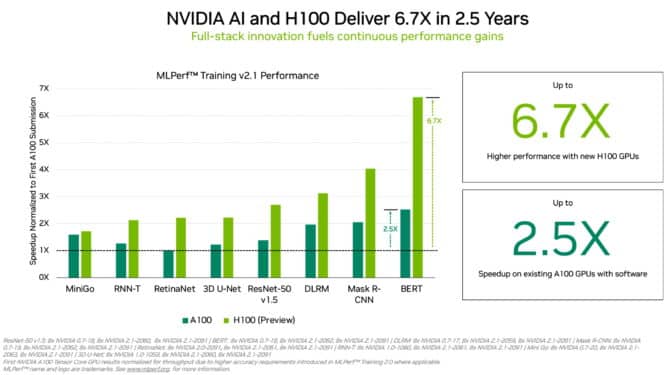

GPU NVIDIA H100 nhanh hơn tới 6,7 lần so với GPU A100 khi chúng lần đầu tiên được đưa đến với MLPerf Training.

GPU NVIDIA H100 nhanh hơn tới 6,7 lần so với GPU A100 khi chúng lần đầu tiên được đưa đến với MLPerf Training.

GPU H100 (hay còn gọi là Hopper) đã nâng cao hiệu suất trên mỗi bộ tăng tốc trong MLPerf Training. Chúng mang lại hiệu suất cao hơn tới 6,7 lần so với các GPU thế hệ trước khi chúng lần đầu tiên được đưa đến quy trình đào tạo MLPerf. Bằng cách so sánh tương tự, GPU A100 hiện nay có sức mạnh gấp 2,5 lần, nhờ những tiến bộ trong phần mềm.

Một phần nhờ vào hệ thống Transformer Engine, Hopper đã xuất sắc trong việc đào tạo mô hình BERT phổ biến để xử lý ngôn ngữ tự nhiên. Đây là một trong những mô hình lớn nhất và có hiệu suất cao nhất trong số các mô hình MLPerf cho AI.

MLPerf mang đến cho người dùng sự tự tin để đưa ra quyết định mua hàng sáng suốt vì các điểm benchmark bao gồm các tải xử lý AI phổ biến nhất hiện nay – thị giác máy tính, xử lý ngôn ngữ tự nhiên, hệ thống đề xuất, học tăng cường và nhiều ứng dụng khác. Các bài test được đánh giá ngang hàng, vì vậy người dùng có thể tin tưởng vào kết quả của chúng.

GPU A100 đạt đỉnh cao mới trong HPC

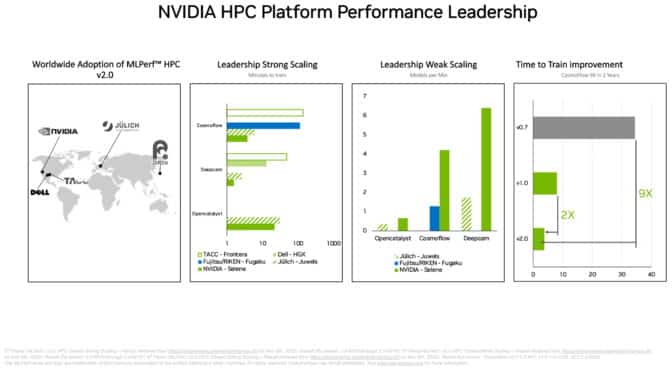

Trong bộ tiêu chuẩn MLPerf HPC riêng biệt, GPU A100 đã đi qua tất cả các bài kiểm tra về đào tạo các mô hình AI với tải xử lý khoa học đòi hỏi cao chạy trên các siêu máy tính. Kết quả cho thấy khả năng của nền tảng NVIDIA AI có thể đáp ứng các thách thức kỹ thuật khắc nghiệt nhất trên thế giới.

Ví dụ: GPU A100 đã huấn luyện các mô hình AI trong thử nghiệm CosmoFlow dành cho vật lý thiên văn nhanh hơn 9 lần so với kết quả tốt nhất hai năm trước trong vòng đầu tiên của MLPerf HPC. Trong cùng một tải xử lý đó, A100 cũng cung cấp thông lượng trên mỗi chip gấp 66 lần so với một sản phẩm thay thế.

Các điểm benchmark HPC đào tạo mô hình cho các công việc trong vật lý thiên văn, dự báo thời tiết và động lực học phân tử. Chúng nằm trong số nhiều lĩnh vực kỹ thuật, như khám phá thuốc, áp dụng AI để thúc đẩy khoa học.

Trong các thử nghiệm trên toàn cầu, GPU A100 dẫn đầu về cả tốc độ và thông lượng đào tạo.

Các trung tâm siêu máy tính ở Châu Á, Châu Âu và Mỹ đã tham gia vào vòng kiểm tra MLPerf HPC mới nhất. Trong lần ra mắt đầu tiên trên điểm chuẩn DeepCAM, Dell Technologies đã cho thấy kết quả rất tốt khi sử dụng GPU NVIDIA A100.

Một hệ sinh thái vô song

Trong các benchmark đào tạo AI dành cho doanh nghiệp, có tổng cộng 11 công ty, bao gồm cả dịch vụ đám mây Microsoft Azure, đã đệ trình bằng cách sử dụng GPU NVIDIA A100, A30 và A40. Các nhà sản xuất hệ thống bao gồm ASUS, Dell Technologies, Fujitsu, GIGABYTE, Hewlett Packard Enterprise, Lenovo và Supermicro đã sử dụng tổng cộng chín hệ thống đạt chứng nhận NVIDIA-Certified Systems cho các bài đệ trình của họ.

Trong vòng cuối cùng, ít nhất ba công ty đã tham gia với NVIDIA để gửi kết quả về tất cả tám tải xử lý đào tạo MLPerf. Tính linh hoạt đó rất quan trọng vì các ứng dụng trong thế giới thực thường yêu cầu một bộ mô hình AI đa dạng.

Các đối tác của NVIDIA tham gia MLPerf vì họ biết đó là một công cụ có giá trị để khách hàng đánh giá các nền tảng và nhà cung cấp AI.

Câu chuyện bên dưới

Nền tảng NVIDIA AI cung cấp toàn bộ thành phần từ chip đến hệ thống, phần mềm và dịch vụ. Điều đó cho phép cải tiến hiệu suất liên tục theo thời gian.

Ví dụ: các bài đệ trình trong các đợt test HPC mới nhất đã áp dụng một tập hợp các kỹ thuật và tối ưu hóa phần mềm được mô tả trong một bài báo kỹ thuật . Họ cùng nhau giảm thời gian chạy trên một benchmark xuống 5 lần, chỉ còn 22 phút từ mức 101 phút trướ đó.

Một bài báo thứ hai mô tả cách NVIDIA tối ưu hóa nền tảng của mình cho các điểm benchmark AI dành cho doanh nghiệp. Ví dụ: chúng tôi đã sử dụng NVIDIA DALI để tải và tiền xử lý dữ liệu một cách hiệu quả cho benchmark thị giác máy tính.

Tất cả phần mềm được sử dụng trong các bài test đều có sẵn từ kho lưu trữ MLPerf, vì vậy bất kỳ ai cũng có thể nhận được những kết quả đẳng cấp thế giới này. NVIDIA liên tục đưa các tối ưu hóa này vào các container có sẵn trên NGC, một hub tập trung phần mềm dành cho các ứng dụng GPU.

Bài viết liên quan

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- NVIDIA Omniverse ft Apple Vision Pro: Mở rộng thế giới quan với VR/AR

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- NVIDIA HGX AI Supercomputer: Nền tảng điện toán AI hàng đầu thế giới

- NVIDIA SuperPOD DGX GB200: Kỷ nguyên của AI nghìn tỷ tham số

- Nền tảng NVIDIA Blackwell: Tạo nên kỷ nguyên điện toán mới