Mặc dù bộ xử lý đồ họa ban đầu được dành cho các game thủ, nhưng các chuyên gia máy tính đều thừa biết rằng chúng cũng cực kỳ có giá trị trong các lĩnh vực khác. Hiện tại, những người khai thác tiền điện tử đang bắt đầu chuyển sang ASIC, giá cả và thị trường tiêu thụ GPU đang ổn định trở lại. Cộng đồng học tập sâu có thể hít thở, thư giãn, mua sắm GPU cho các nhu cầu mới và chạy các mô hình training.

NVIDIA cho thấy các game thủ không còn là đối tượng mục tiêu duy nhất cho các sản phẩm của họ nữa. Vào tháng 9 năm 2018, họ đã phát hành NVIDIA Tesla T4: card suy luận (inference) dùng trên máy chủ chuyên dụng cho Deep Learning. NVIDIA Tesla V100, chuyên dụng cho đào tạo (training), là một sản phẩm trong dòng card đặc biệt dành cho Deep Learning của họ. Các card này được trang bị tính năng gọi là Tensor Core để tăng hiệu suất cho neural network. Các Tensor Core tương tự cũng có mặt trong các thế hệ card phổ thông mới nhất như RTX 2060, RTX 2070, RTX 2080 và RTX 2080 Ti và các mẫu card “SUPER” mới. Nếu bạn tìm một vòng trên mạng, bạn sẽ thấy rằng 2080 Ti thường được đề xuất nhiều nhất cho machine learning tại thời điểm này. Trong bài này, chúng ta sẽ xem xét đầy đủ các yếu tố để .

GPU card chuyên dùng cho máy chủ

Trước tiên, có một sự khác biệt sâu sắc giữa việc định giá card phổ thông và card dành cho máy chủ mà NVIDIA bán. Ví dụ với Tesla V100: đây là GPU card máy chủ dựa trên kiến trúc Volta GV100. Tương tự, có một card phổ thông, Titan V, dựa trên cùng một kiến trúc với thông số kỹ thuật gần như giống hệt nhau. Cả hai đều sở hữu 5120 CUDA core, TDP 250 Watts và khoảng 15 TFLOPS hiệu suất single-precision floating point. V100 có nhiều bộ nhớ hơn: nó có 16GB bộ nhớ HBM2 chạy ở tốc độ xung nhịp cao hơn một chút so với dung lượng bộ nhớ 12GB của Titan V. Sự khác biệt chính nằm ở giá: Titan V được bán ra ở khoảng 3.000USD trở lại, Tesla V100 thì ở khoảng 10.000USD! Điều gì có thể có thể lý giải cho sự chênh lệch giá quá lớn này? NVIDIA giải thích rằng Tesla V100 có tất cả các đặc điểm của card chuyên dùng trên máy chủ: bảo hành 3 năm, được thiết kế và kiểm chứng để sử dụng trên rack server trong thời gian dài. Có một điều là, EULA đi kèm với các driver cần thiết cho các card này thể hiện việc KHÔNG được sử dụng card phổ thông trong các trung tâm dữ liệu. Đây là lý do tại sao AWS, Azure và Google Cloud không cung cấp các card Titan V. Về cơ bản, bạn cần trả thêm khoảng 7.000USD để có thể sử dụng GPU card trong trung tâm dữ liệu. Nếu bạn vẫn muốn dùng Titan V trong data center (nếu nơi nào đó cho phép) thì việc nó có… phát lửa hay không thì không ai dám chắc! Nếu bạn là một nhà nghiên cứu khoa học và rất nghiêm túc với dự án của mình, bạn cần tìm hiểu sâu về các điều kiện để một máy chủ vận hành trong data center, và những yếu tố đảm bảo cho việc GPU chạy liên tục trong thời gian dài.

Vấn đề hiệu suất

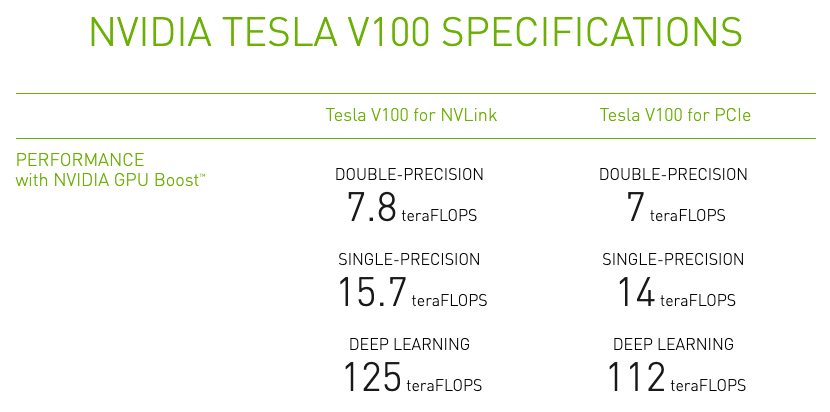

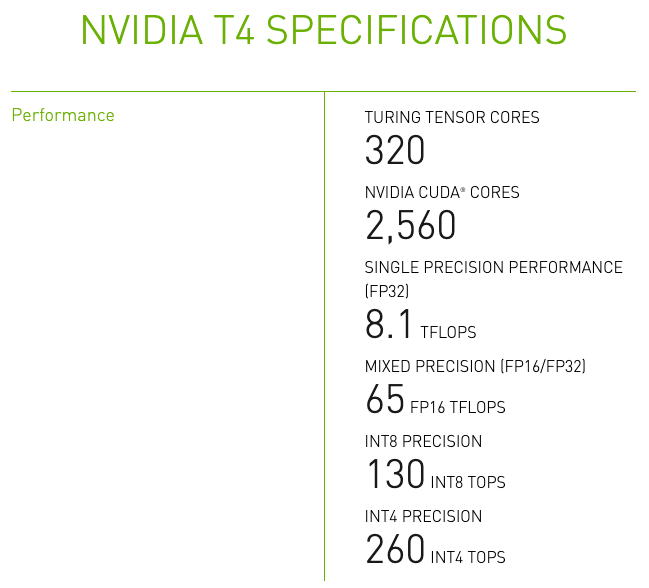

Chúng ta sẽ cùng tìm hiểu về hiệu năng của Tesla V100 và T4, vì đây là những mẫu GPU mà NVIDIA chủ yếu nhắm đến deep learning.

Hiệu suất deep learning: Đối với Tesla V100, gpu này có 125 TFLOPS, so với hiệu suất single-precision là 15 TFLOPS. Đây là một thông số khủng! Làm thế nào để họ có được điều này? Nó dựa trên cái gọi là “mixed precision performance” của NVIDIA. Về cơ bản, bằng cách sử dụng một số thủ thuật toán học, NVIDIA đã tìm cách kết hợp cả hai lợi thế của FP32 cũng như FP16 training: cho kết quả nhanh và hội tụ chính xác. 640 Tensor Cores được giới thiệu trong Tesla V100 được chế tạo đặc biệt để tăng tốc half-precision training, cho phép họ đạt được các kết quả hiệu suất phi thường này. Các chuyên gia học sâu sẽ thốt ra: kỳ diệu, làm thế nào để dùng được nó? Nếu bạn đang sử dụng TensorFlow, bạn cần một “NVIDIA NGC TensorFlow 19.03 container” và chạy nó trong một Docker instance. Sau đó, kích hoạt một biến môi trường và bạn đã sẵn sàng!

Thông số kỹ thuật Tesla V100:

Thông số kỹ thuật Tesla T4:

Các thông số hiệu năng của Tesla V100, T4 so với các dòng card khác

| VRAM | MEM PF | MEM SP | MHZ | CUDAs | MHZ x CUDAs | FP32 TFLOPS | BIZON-TECH | PERF AGG | TCORES | ENERGY | ENPRICE | PRICE | |

| Tesla T4 | 16 | 1.08 | 320 | 585 | 2560 | 1617 | 8 | 1.5 | 320 | 70 | € 140.00 | € 2,500.00 | |

| Tesla V100 | 16 | 1.08 | 900 | 1530 | 5376 | 8883 | 15 | 4.7 | 672 | 250 | € 500.00 | € 10,000.00 | |

| GTX 1080 | 8 | 0.92 | 320 | 1632 | 2560 | 3844 | 8.9 | 2.3 | 0 | 150 | € 300.00 | € 350.00 | |

| GTX 1070 | 8 | 0.92 | 256 | 1506 | 1920 | 2660 | 6.4 | 1.6 | 0 | 150 | € 300.00 | € 250.00 | |

| GTX 1080 Ti | 11 | 0.98 | 484 | 1596 | 3584 | 5606 | 11.1 | 127 | 3.2 | 0 | 250 | € 500.00 | € 500.00 |

| RTX 2060 Super | 8 | 0.92 | 448 | 1470 | 2176 | 2943 | 7.2 | 1.8 | 272 | 175 | € 350.00 | € 360.00 | |

| GTX 1660 Super | 6 | 0.88 | 336 | 1530 | 1408 | 1896 | 5 | 1.2 | 0 | 125 | € 250.00 | € 250.00 | |

| GTX 1070 Ti | 8 | 0.92 | 256 | 1607 | 2432 | 3596 | 8.2 | 2.2 | 0 | 180 | € 360.00 | € 500.00 | |

| RTX 2070 Super | 8 | 0.92 | 448 | 1605 | 2560 | 3780 | 9.1 | 2.3 | 320 | 175 | € 350.00 | € 590.00 | |

| RTX 2060 | 6 | 0.88 | 336 | 1365 | 1920 | 2306 | 6.5 | 246 | 1.5 | 240 | 160 | € 320.00 | € 360.00 |

| GTX 1660 Ti | 6 | 0.88 | 288 | 1500 | 1536 | 2028 | 5.4 | 1.3 | 0 | 120 | € 240.00 | € 320.00 | |

| RTX 2080 Super | 8 | 0.92 | 496 | 1650 | 3072 | 4663 | 11.2 | 2.9 | 384 | 215 | € 430.00 | € 815.00 | |

| RTX 2070 | 8 | 0.92 | 448 | 1410 | 2304 | 2989 | 7.5 | 156 | 1.9 | 288 | 175 | € 350.00 | € 490.00 |

| RTX 2080 | 8 | 0.92 | 448 | 1515 | 2944 | 4103 | 10 | 134 | 2.5 | 368 | 250 | € 500.00 | € 815.00 |

| GTX 1060 | 6 | 0.88 | 192 | 1506 | 1280 | 1696 | 4.4 | 1.1 | 0 | 120 | € 240.00 | € 350.00 | |

| RTX 2080 Ti | 11 | 0.98 | 616 | 1350 | 4352 | 5758 | 13.5 | 98 | 3.5 | 544 | 250 | € 500.00 | € 1,260.00 |

| GTX Titan X | 12 | 1 | 384 | 1000 | 3072 | 3072 | 6.7 | 1.8 | 0 | 250 | € 500.00 | € 700.00 | |

| Quadro RTX 4000 | 8 | 0.92 | 416 | 1005 | 2304 | 2130 | 7.1 | 1.6 | 288 | 160 | € 320.00 | € 1,100.00 | |

| Quadro P600 | 4 | 0.84 | 82 | 1266 | 640 | 680.6 | 1.9 | 0.5 | 0 | 47 | € 94.00 | € 330.00 | |

| Tesla K40 | 12 | 1 | 288 | 745 | 2888 | 2152 | 4.3 | 1.2 | 0 | 245 | € 490.00 | € 1,200.00 |

Giải thích

| VRAM | Dung lượng bộ nhớ GPU |

| MEM PF | Yếu tố bottleneck được tính toán cho dung lượng bộ nhớ; xác định qua thực nghiệm. |

| MEM SP | Tốc độ bộ nhớ tính bằng GB / s |

| MHZ | Tốc độ cơ sở của chip |

| CUDA | Số lượng lõi CUDA |

| MHZ x CUDA | Chỉ báo hiệu suất 1: Tốc độ cơ sở nhân với số CUDA cores nhân với MEM PF và chia cho 1000 |

| TFLOPS FP32 | Chỉ báo hiệu suất 2: Hiệu suất Single-precision floating point |

| BIZON-TECH | Chỉ số hiệu suất 3: Hiệu suất của TensorFlow 1.4 VGG16 |

| PERG-AGG | Hiệu suất tổng hợp: trung bình có trọng số của chỉ số hiệu suất 1 và 2 (không bao gồm 3 vì chúng là N/A cho một số thẻ) |

| TCORES | Số lượng Tensor Cores |

| ENERGY | TDP ước tính của việc sử dụng năng lượng khi tải 100% |

| ENPRICE | Dự toán chi phí hoạt động 100% mỗi năm |

| PRICE | Giá mới hiện tại hoặc giá đã qua sử dụng (EU) |

Bài viết liên quan