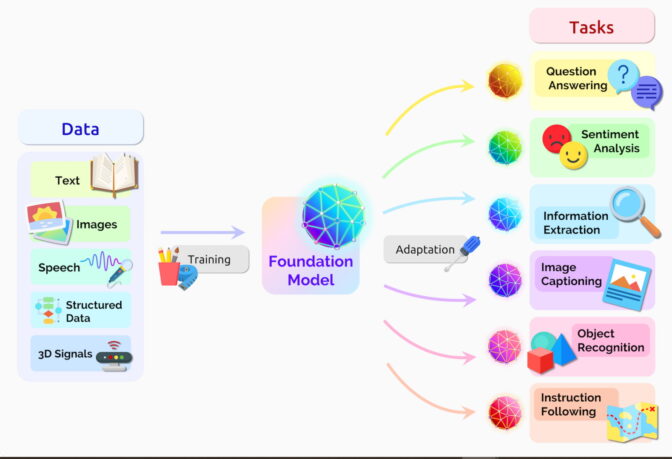

Các mô hình nền tảng (Foundation Model) là các mạng nơ-ron nhân tạo AI được đào tạo trên các bộ dữ liệu khổng lồ chưa được gắn nhãn để xử lý nhiều loại công việc khác nhau, từ dịch văn bản cho đến phân tích hình ảnh y khoa.

Những chiếc micro đang bật và cuộn băng đang chạy trong phòng thu nơi ban nhạc The Miles Davis Quintet đang ghi âm hàng chục giai điệu vào năm 1956 cho Prestige Records.

Khi một kỹ sư hỏi tên bài hát tiếp theo, Davis đáp lại, “Tôi sẽ chơi nó và cho bạn biết nó là gì sau”.

Giống như nghệ sĩ kèn và nhà soạn nhạc jazz, các nhà nghiên cứu đã và đang tạo ra các mô hình AI với tốc độ chóng mặt, khám phá các kiến trúc và ứng dụng mới. Tập trung vào việc cày xới mảnh đất mới, đôi khi họ để lại cho người khác nhiệm vụ phân loại công việc của họ.

Một nhóm gồm hơn một trăm nhà nghiên cứu của Stanford đã hợp tác để làm điều đó trong một bài báo dài 214 trang được phát hành vào mùa hè năm 2021.

Họ cho biết các Transformer Model, các Mô hình ngôn ngữ lớn (Large Language Model) và các mạng nơ-ron khác vẫn đang được xây dựng – là một phần của danh mục mới quan trọng mà họ đặt tên là các Mô hình nền tảng (Foundation Model).

Định nghĩa Mô hình Nền tảng

“Một mô hình nền tảng là một mạng nơ-ron AI – được đào tạo trên hàng núi dữ liệu thô, thường là với phương pháp học không giám sát (unsupervised learning), có thể được điều chỉnh để hoàn thành nhiều loại nhiệm vụ”, bài báo ghi.

Họ viết: “Quy mô và phạm vi tuyệt đối của các mô hình nền tảng trong vài năm qua đã mở rộng trí tưởng tượng của chúng tôi về những gì có thể”.

Hai khái niệm quan trọng giúp xác định danh mục lớn này chính là: Thu thập dữ liệu dễ dàng hơn và các cơ hội rộng mở ra như đường chân trời.

Không gắn nhãn, nhiều cơ hội

Các mô hình nền tảng thường học từ các bộ dữ liệu chưa được gắn nhãn, tiết kiệm thời gian và chi phí mô tả thủ công từng mục trong các bộ dữ liệu lớn.

Các mạng nơ-rơn trước đó được điều chỉnh trong phạm vi hẹp cho các nhiệm vụ cụ thể. Với một chút tinh chỉnh, các mô hình nền tảng có thể xử lý các công việc từ dịch văn bản đến phân tích hình ảnh y khoa (medical image).

Các mô hình nền tảng đang thể hiện “hành vi ấn tượng” và đang được triển khai ở quy mô lớn, nhóm cho biết trên website Trung tâm nghiên cứu của mình được thành lập để nghiên cứu chúng. Cho đến nay, họ đã đăng hơn 50 bài báo về các mô hình nền tảng từ các nhà nghiên cứu nội bộ.

“Tôi nghĩ chúng ta mới khám phá được một phần rất nhỏ những khả năng của các mô hình nền tảng hiện có, chưa nói đến những mô hình trong tương lai” – Percy Liang, Giám đốc của trung tâm, trong bài phát biểu khai mạc workshop đầu tiên về các mô hình nền tảng cho hay.

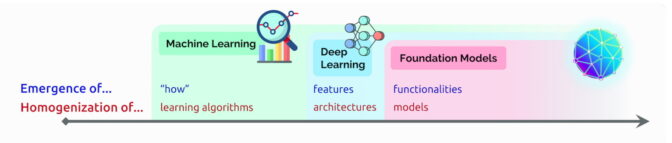

Sự xuất hiện và đồng nhất hóa của AI

Trong buổi nói chuyện đó, Liang đã đặt ra hai thuật ngữ để mô tả các mô hình nền tảng:

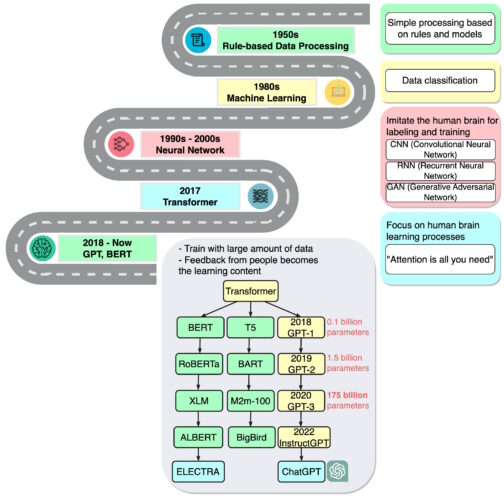

Sự xuất hiện (Emergence) đề cập đến các tính năng AI vẫn đang được khám phá, chẳng hạn như nhiều kỹ năng non trẻ trong các mô hình nền tảng. Ông gọi sự pha trộn giữa các thuật toán AI và sự đồng nhất hóa các kiến trúc mô hình là một xu hướng giúp hình thành nên các mô hình nền tảng. (Xem biểu đồ bên dưới).

Lĩnh vực tiếp tục phát triển nhanh.

Một năm sau khi nhóm xác định các mô hình nền tảng, những người theo dõi công nghệ khác đã đặt ra một thuật ngữ liên quan – generative AI. Đó là một thuật ngữ chung cho các transformer, mô hình ngôn ngữ lớn, mô hình khuếch tán (diffusion model) và các mạng nơ-ron khác, thu hút trí tưởng tượng của mọi người vì chúng có thể tạo văn bản, hình ảnh, âm nhạc, phần mềm,…

Các giám đốc điều hành của công ty liên doanh Sequoia Capital đã chia sẻ quan điểm của mình trong một AI Podcast gần đây cho biết: “Generative AI có tiềm năng mang lại hàng nghìn tỷ đô la giá trị kinh tế”.

Sơ lược về lịch sử của các Mô hình nền tảng

Ashish Vaswani, một doanh nhân và cựu nhân viên cấp cao Research Scientist tại Google Brain, người đứng đầu công trình nghiên cứu về các Transformer năm 2017 cho biết: “Chúng ta đang ở trong thời đại mà các phương pháp đơn giản như mạng nơ-ron nhân tạo mang lại cho chúng ta sự bùng nổ các khả năng mới”.

Công trình đó đã truyền cảm hứng cho các nhà nghiên cứu tạo ra BERT và các mô hình ngôn ngữ lớn khác, khiến năm 2018 trở thành “thời điểm bước ngoặt” cho xử lý ngôn ngữ tự nhiên, một báo cáo về AI cho biết vào cuối năm đó.

Google đã phát hành BERT dưới dạng phần mềm mã nguồn mở, tạo ra một nhóm phần mềm tiếp theo và bắt đầu cuộc chạy đua xây dựng các LLM ngày càng lớn hơn, mạnh mẽ hơn. Sau đó, nó áp dụng công nghệ này vào engine tìm kiếm của mình để người dùng có thể đặt câu hỏi bằng những câu đơn giản.

Vào năm 2020, các nhà nghiên cứu tại OpenAI đã công bố một transformer mang tính bước ngoặt khác, GPT-3. Trong vòng vài tuần, mọi người đã sử dụng nó để sáng tác thơ, bài hát, tạo chương trình, website…

Các nhà nghiên cứu viết: “Các mô hình ngôn ngữ có nhiều ứng dụng hữu ích cho xã hội”.

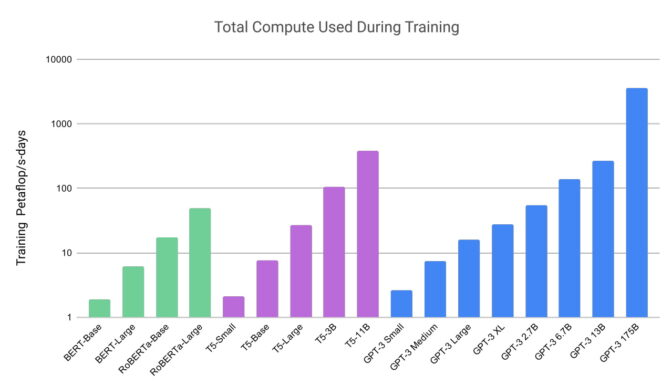

Công việc của họ cũng cho thấy các mô hình này có thể lớn và chuyên sâu về tính toán như thế nào. GPT-3 đã được đào tạo trên một bộ dữ liệu có gần một nghìn tỷ từ (word) và có tới 175 tỷ tham số, một thước đo chính về sức mạnh và độ phức tạp của mạng nơ-ron nhân tạo.

“Tôi chỉ nhớ mình đã bị choáng ngợp bởi những thứ mà nó có thể làm được” – Liang nói về GPT-3 trong một podcast.

Phiên bản mới nhất, ChatGPT – được đào tạo trên 10.000 GPU NVIDIA – thậm chí còn hấp dẫn hơn, thu hút hơn 100 triệu người dùng chỉ sau hai tháng. Việc phát hành nó được gọi là khoảnh khắc iPhone cho AI vì nó đã giúp rất nhiều người thấy được cách họ có thể sử dụng công nghệ này.

Từ văn bản đến hình ảnh

Cùng thời điểm ChatGPT ra mắt, một loại mạng nơ-ron nhân tạo khác, được gọi là Mô hình khuếch tán, đã gây chú ý. Khả năng biến mô tả văn bản thành hình ảnh nghệ thuật của chúng đã thu hút người dùng thông thường tạo ra những hình ảnh tuyệt vời lan truyền trên mạng xã hội.

Bài báo đầu tiên mô tả một mô hình khuếch tán đã xuất hiện với một chút phô trương vào năm 2015. Nhưng giống như các Transformer, kỹ thuật mới này nhanh chóng bùng cháy.

Các nhà nghiên cứu đã đăng hơn 200 bài báo về các mô hình khuếch tán vào năm ngoái, theo danh sách được duy trì bởi James Thornton, một nhà nghiên cứu AI tại Đại học Oxford.

Trong một tweet, David Holz – Giám đốc điều hành của Midjourney tiết lộ rằng dịch vụ chuyển văn bản thành hình ảnh, dựa trên sự khuếch tán của ông có hơn 4,4 triệu người dùng. Ông cho biết trong một cuộc phỏng vấn rằng việc phục vụ chúng đòi hỏi hơn 10.000 GPU NVIDIA chủ yếu dành cho suy luận AI.

Hàng chục mô hình được sử dụng

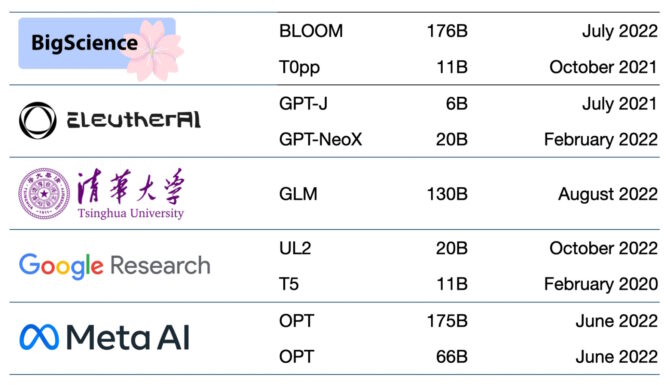

Hàng trăm Mô hình nền tảng hiện có sẵn. Một tờ báo đã liệt kê và phân loại hơn 50 mô hình transfomer (xem biểu đồ bên dưới).

Nhóm Stanford đã đánh giá 30 mô hình nền tảng, lưu ý rằng lĩnh vực này đang phát triển quá nhanh nên họ đã không xem xét một số mô hình mới và nổi bật.

Startup NLP Cloud, một thành viên của chương trình NVIDIA Inception – nuôi dưỡng các công ty khởi nghiệp tiên tiến, cho biết họ sử dụng khoảng 25 mô hình ngôn ngữ lớn trong một dịch vụ thương mại phục vụ các hãng hàng không, hiệu thuốc và những người dùng khác. Các chuyên gia kỳ vọng rằng tỷ lệ ngày càng tăng của các mô hình sẽ được tạo thành mã nguồn mở trên các trang web như model hub của Hugging Face.

Các mô hình nền tảng cũng ngày càng lớn hơn và phức tạp hơn.

Đó là lý do, thay vì xây dựng các mô hình mới từ đầu, nhiều doanh nghiệp đã tùy chỉnh các mô hình nền tảng được đào tạo trước để tăng tốc hành trình của họ vào AI.

Các nền tảng trong Cloud

Một công ty đầu tư mạo hiểm liệt kê 33 trường hợp sử dụng cho AI tạo sinh (generative AI) từ tạo quảng cáo cho đến tìm kiếm ngữ nghĩa.

Các dịch vụ cloud chính đã sử dụng các mô hình nền tảng được một thời gian. Ví dụ, Microsoft Azure đã làm việc với NVIDIA để triển khai 1 transformer cho dịch vụ Translator của mình. Nó giúp các nhân viên thảm họa hiểu được ngôn ngữ Haiti Creole trong khi họ đang ứng phó với trận động đất mạnh 7 độ richter.

Vào tháng 2, Microsoft đã công bố các kế hoạch để nâng cao trình duyệt và công cụ tìm kiếm của mình với ChatGPT và các đổi mới liên quan. Công bố cho biết: “Chúng tôi coi những công cụ này như một AI Copilot dành cho web”.

Google đã công bố Bard, một dịch vụ AI đàm thoại thử nghiệm. Nó có kế hoạch kết nối nhiều sản phẩm của mình với sức mạnh của các mô hình nền tảng như LaMDA, PaLM, Imagen và MusicLM.

“AI là công nghệ sâu sắc nhất mà chúng tôi đang nghiên cứu ngày nay”, blog của công ty viết.

Các công ty khởi nghiệp cũng nhận được sự hỗ trợ

Công ty khởi nghiệp Jasper dự kiến sẽ đạt doanh thu hàng năm là 75 triệu USD từ các sản phẩm viết bản sao cho các công ty như VMware. Nó đang dẫn đầu một lĩnh vực gồm hơn chục công ty tạo văn bản, bao gồm cả Writer – một thành viên của NVIDIA Inception.

Các thành viên khác của Inception trong lĩnh vực bao gồm rinna có trụ sở tại Tokyo đã tạo ra các chatbot được hàng triệu người ở Nhật Bản sử dụng. Tại Tel Aviv, Tabnine điều hành một dịch vụ generative AI được tự động hóa tới 30% code do một triệu nhà phát triển trên toàn cầu viết.

Nền tảng dành cho chăm sóc sức khỏe

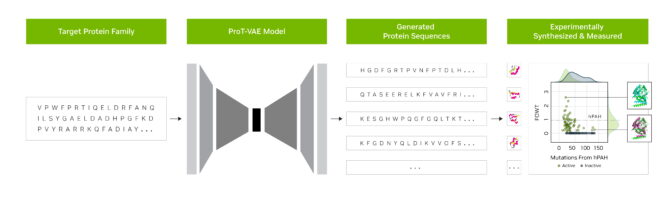

Các nhà nghiên cứu tại công ty khởi nghiệp Evozyne đã sử dụng các mô hình nền tảng trong NVIDIA BioNeMo để tạo ra hai loại protein mới. Một loại có thể điều trị một căn bệnh hiếm gặp và một loại khác có thể giúp thu giữ carbon trong khí quyển.

BioNeMo, một nền tảng phần mềm và dịch vụ đám mây dành cho generative AI trong nghiên cứu chế tạo thuốc, cung cấp các công cụ để đào tạo, chạy suy luận và triển khai các mô hình AI phân tử sinh học tùy chỉnh. Nó bao gồm MegaMolBART, một mô hình generative AI cho hóa học do NVIDIA và AstraZeneca phát triển.

“Giống như các mô hình ngôn ngữ AI có thể tìm hiểu mối quan hệ giữa các từ trong câu, mục tiêu của chúng tôi là mạng nơ-ron nhân tạo được đào tạo dựa trên dữ liệu cấu trúc phân tử sẽ có thể tìm hiểu mối quan hệ giữa các nguyên tử của các phân tử trong thế giới thực”. Ola Engkvist, Trưởng bộ phận AI phân tử, khoa học khám phá và R&D tại AstraZeneca cho biết khi công trình được công bố.

Một cách riêng biệt, trung tâm y tế học thuật của Đại học Florida đã hợp tác với các nhà nghiên cứu của NVIDIA để tạo ra GatorTron. Mô hình ngôn ngữ lớn nhằm mục đích trích xuất những hiểu biết từ khối lượng dữ liệu lâm sàng khổng lồ để đẩy nhanh nghiên cứu y học.

Một trung tâm ở Stanford đang áp dụng các mô hình khuếch tán mới nhất để cải tiến hình ảnh y khoa. NVIDIA cũng giúp các công ty chăm sóc sức khỏe và bệnh viện sử dụng AI trong hình ảnh y khoa, đẩy nhanh quá trình chẩn đoán các căn bệnh chết người.

Nền tảng AI cho doanh nghiệp

Một framework mới khác, NVIDIA NeMo Megatron, nhằm mục đích cho phép bất kỳ doanh nghiệp nào tạo ra các transformer với hàng tỷ hoặc nghìn tỷ tham số của riêng mình để hỗ trợ sức mạnh cho các chatbot tùy chỉnh, trợ lý cá nhân và các ứng dụng AI khác.

Nó đã tạo ra mô hình Natural Language Generation 530 tham số, (MT-NLG) hỗ trợ cho TJ, hình đại diện Toy Jensen đã góp một phần trong keynote tại NVIDIA GTC năm ngoái.

Các mô hình nền tảng được kết nối với các nền tảng 3D như NVIDIA Omniverse – sẽ là chìa khóa để đơn giản hóa quá trình phát triển metaverse, sự tiến hóa 3D của Internet. Những mô hình này sẽ cung cấp sức mạnh cho các ứng dụng và nội dung dành cho người dùng giải trí và công nghiệp.

Các nhà máy và nhà kho đã và đang áp dụng các mô hình nền tảng bên trong các bản sao kỹ thuật số (digital twins), các mô phỏng thực tế giúp tìm ra các cách làm việc hiệu quả hơn.

Các mô hình nền tảng có thể tạo điều kiện thuận lợi cho công việc huấn luyện xe tự hành và rô-bốt, hỗ trợ công nhân trên sàn nhà máy và các trung tâm logistic như mô tả bên dưới.

Những cách sử dụng mới cho các mô hình nền tảng đang xuất hiện hàng ngày, cũng như những thách thức trong việc áp dụng chúng.

Một số bài báo về các mô hình AI nền tảng và tạo sinh mô tả các rủi ro như:

- khuếch đại thiên vị tiềm ẩn trong những bộ dữ liệu khổng lồ được sử dụng để huấn luyện các mô hình.

- giới thiệu thông tin không chính xác hoặc sai lệch trong hình ảnh hoặc video.

- vi phạm quyền sở hữu trí tuệ của các tác phẩm hiện có.

“Do các hệ thống AI trong tương lai có thể sẽ phụ thuộc nhiều vào các mô hình nền tảng, chúng ta, với tư cách là một cộng đồng, bắt buộc phải cùng nhau phát triển các nguyên tắc chặt chẽ hơn cho các mô hình nền tảng và hướng dẫn cho sự phát triển và triển khai có trách nhiệm của chúng” – theo bài báo của Stanford về các mô hình nền tảng.

Các ý tưởng hiện tại về các biện pháp bảo vệ bao gồm lọc các lời nhắc và output của chúng, hiệu chỉnh lại các mô hình một cách nhanh chóng và làm sạch những bộ dữ liệu lớn.

“Đây là những vấn đề chúng tôi đang làm việc với tư cách là một cộng đồng nghiên cứu”, Bryan Catanzaro, Phó chủ tịch nghiên cứu Học sâu ứng dụng tại NVIDIA cho biết. “Để những mô hình này thực sự được triển khai rộng rãi, chúng tôi phải đầu tư rất nhiều vào vấn đề an toàn”.

Đây lại là một lĩnh vực nữa mà các nhà nghiên cứu và nhà phát triển AI đang khai thác khi họ tạo ra tương lai.

Theo NVIDIA

Bài viết liên quan

- PowerScale: Nền tảng kiến trúc cho các tác vụ GenAI

- NVIDIA Hopper tiếp tục dẫn đầu hiệu suất Generative AI trong MLPerf

- NVIDIA hỗ trợ hành trình hướng tới Generative AI thuận lợi hơn cho các doanh nghiệp

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- Đơn giản hóa phát triển Generative AI tuỳ chỉnh với NVIDIA NeMo Microservices

- NVIDIA CEO: “Chúng tôi đã tạo ra chip xử lý cho kỷ nguyên AI tạo sinh”