Xử lý suy luận AI cho mọi doanh nghiệp

Với kiến trúc NVIDIA Ampere Tensor Cores và Multi-Instance GPU (MIG), GPU NVIDIA A30 mang lại sự đảm bảo tài nguyên xử lý tăng tốc cho các workload đa dạng, bao gồm cả suy luận AI ở quy mô lớn và các ứng dụng hiệu suất cao (HPC). Bằng cách kết hợp băng thông bộ nhớ và mức tiêu thụ điện năng thấp trong thiết kế chuẩn PCIe tối ưu cho các máy chủ phổ biến, A30 cho phép triển khai linh hoạt trong trung tâm dữ liệu và mang lại giá trị tối đa cho doanh nghiệp.

Giải pháp Trung tâm Dữ liệu cho nền tảng IT hiện đại

Các kiến trúc NVIDIA Ampere là một phần của giải pháp hợp nhất NVIDIA EGX, kết hợp các building-block của phần cứng, phần mềm, internet, các mô hình AI tối ưu hóa và ứng dụng từ NVIDIA NGC. Đại diện cho nền tảng AI và HPC end-to-end mạnh mẽ cho trung tâm dữ liệu, cho phép các nhà nghiên cứu nhanh chóng cung cấp các kết quả thực tế và triển khai các giải pháp vào sản xuất trên quy mô lớn.

DEEP LEARNING TRAINING

Đào tạo AI — Thông lượng cao hơn gấp 3 lần so với V100 và hơn 6 lần so với T4

Đào tạo mô hình AI cho những thách thức tiếp theo như AI đàm thoại đòi hỏi sức mạnh tính toán lớn và khả năng mở rộng lớn.

NVIDIA A30 Tensor Cores với Tensor Float (TF32) cung cấp hiệu suất gấp 10 lần so với NVIDIA T4 và tăng lên 2 lần với độ chính xác hỗn hợp tự động và FP16, thông lượng lên đến 20 lần. Khi kết hợp với NVIDIA NVLINK, PCIe Gen4, NVIDIA networking và NVIDIA Magnum IO SDK, bạn có thể mở rộng quy mô lên hàng nghìn GPU.

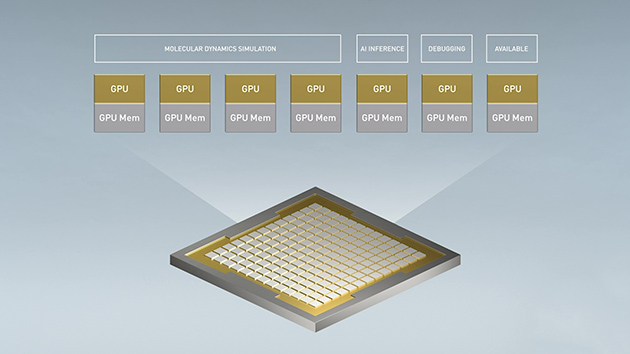

Với Tensor Cores và Multi-Instant GPU cho phép A30 được sử dụng cho các workload một cách linh hoạt, vận hành liên tục cả ngày. Dùng để suy luận ở cấp độ sản xuất ngay cả ở đỉnh điểm về nhu cầu và một phần của GPU có thể được tái cấp phát để nhanh chóng phục vụ cho việc đào tạo lại các mô hình tương tự ở lúc thấp điểm.

NVIDIA đã lập nhiều kỷ lục hiệu năng của MLPerf, một tiêu chuẩn đánh giá toàn cầu cho hiệu suất đào tạo AI.

DEEP LEARNING INFERENCE

A30 tận dụng các tính năng đột phá để tối ưu hóa các workload suy luận. Tăng tốc từ FP64 đến TF32 và INT4. Hỗ trợ tối đa bốn MIG cho mỗi GPU vật lý, A30 cho phép nhiều lớp mạng hoạt động đồng thời trong các phân vùng phần cứng an toàn, với chất lượng dịch vụ được đảm bảo (QoS). Hỗ trợ structural sparsity (cấu trúc thưa thớt) mang lại hiệu suất cao hơn gấp 2 lần so với mức hiệu suất suy luận khác của A30.

Hiệu suất AI dẫn đầu thị trường của NVIDIA đã được chứng minh trong MLPerf Inference. Kết hợp với NVIDIA Triton Inference Server, dễ dàng triển khai AI trên quy mô lớn, A30 mang lại hiệu suất đột phá cho mọi doanh nghiệp.

Suy luận AI — Thông lượng cao hơn tới 3 lần so với V100 AI trong thời gian thực

Thông lượng suy luận lớn BERT cho độ trễ <10ms

Suy luận AI — Thông lượng cao hơn gấp 3 lần so với T4 phân loại hình ảnh theo thời gian thực

Thông lượng suy luận RN50 v1.5 cho Độ trễ <7ms

HIGH-PERFORMANCE COMPUTING

HPC — Thông lượng cao hơn tới 1,1 lần so với V100 và gấp 8 lần so với T4

Để mở ra những khám phá thế hệ mới, các nhà khoa học sử dụng chức năng mô phỏng để hiểu rõ hơn về thế giới xung quanh chúng ta.

NVIDIA A30 có kiến trúc FP64 NVIDIA Ampere Tensor Cores mang lại bước nhảy lớn về hiệu suất HPC kể từ khi GPU ra đời. Kết hợp với 24 GB bộ nhớ GPU với băng thông 933 GByte/s, các nhà nghiên cứu có thể xử lý các phép tính với độ chính xác lên gấp đôi. Các ứng dụng HPC cũng tận dụng TF32 để tăng thông lượng cao hơn cho các chuyển động hạt nhân ma trận dày đặc, chính xác.

Sự kết hợp giữa FP64 Tensor Cores và MIG cho phép các tổ chức nghiên cứu phân vùng GPU một cách an toàn, cho phép nhiều nhà nghiên cứu có thể truy cập tài nguyên xử lý với QoS và mức sử dụng GPU tối đa. Các doanh nghiệp triển khai AI có thể sử dụng khả năng suy luận của A30 trong thời gian cao điểm và sau đó sử dụng lại các tài nguyên xử lý tương tự cho các workload đào tạo HPC và AI trong thời gian thấp điểm.

HIGH-PERFORMANCE DATA ANALYTICS

Các nhà khoa học về dữ liệu cần có khả năng phân tích, hình dung và biến các bộ dữ liệu khổng lồ thành thông tin chi tiết. Nhưng các giải pháp mở rộng quy mô thường trở nên phức tạp, khó khăn bởi các bộ dữ liệu nằm rải rác trên nhiều máy chủ.

Với việc tăng tốc máy chủ bằng GPU A30 sẽ cung cấp sức mạnh tính toán cùng với bộ nhớ HBM2 lớn, băng thông bộ nhớ 933 GB/s, khả năng mở rộng với NVlink thực sự cần thiết để giải quyết khối lượng công việc phức tạp này. Được kết hợp với NVIDIA InfiniBand, NVIDIA Magnum IO và RAPIDS, bao gồm RAPIDS Accelerator cho Apache Spark, nền tảng trung tâm dữ liệu NVIDIA tăng tốc khối lượng công việc khổng lồ với hiệu năng và hiệu quả chưa từng có.

SẴN SÀNG SỬ DỤNG CHO DOANH NGHIỆP

A30 với khả năng hỗ trợ MIG cho phép tối đa hóa việc khai thác hạ tầng tăng tốc GPU. Với MIG, GPU A30 có thể được phân chia thành bốn phiên bản độc lập, cho phép nhiều người dùng truy cập vào khả năng tăng tốc GPU.

MIG hoạt động với Kubernetes, Containers, và các hệ thống ảo hóa máy chủ dựa trên Hypervisor. MIG cho phép các nhà quản lý hạ tầng cung cấp một GPU có kích thước phù hợp, với QoS đảm bảo, mở rộng phạm vi tiếp cận của tài nguyên xử lý tăng tốc cho mọi người dùng.

NVIDIA AI ENTERPRISE

NVIDIA AI Enterprise, một bộ phần mềm AI và phân tích dữ liệu cloud-native, được chứng nhận để chạy với A30 trong hạ tầng ảo hóa dựa trên Hypervisor với VMware vSphere. Điều này cho phép việc quản lý và mở rộng workload AI trong môi trường hybrid-cloud. Xem thêm →

Các hệ thống được NVIDIA chứng nhận (NVIDIA-CERTIFIED SYSTEMS)

Các hệ thống được NVIDIA chứng nhận cho NVIDIA A30 mang năng lực tăng tốc xử lý và sự an toàn về mạng vào bên trong các máy chủ trong trung tâm dữ liệu doanh nghiệp, được xây dựng và kinh doanh bởi các đối tác OEM của NVIDIA như Supermicro. Chương trình này cho phép khách hàng xác định và triển khai các hệ thống cho các ứng dụng AI hiện đại và truyền thống đa dạng từ danh mục NVIDIA NGC trên một hạ tầng hiệu suất cao, hiệu quả về chi phí và khả năng mở rộng cao. Xem thêm →

Bài viết liên quan

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- Hướng dẫn build một cụm GPU cho AI

- GDDR6 vs HBM – Định nghĩa các loại bộ nhớ GPU

- NVIDIA Omniverse ft Apple Vision Pro: Mở rộng thế giới quan với VR/AR

- Tôi có cần CPU kép không?

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn