Điểm qua khái niệm Deep Learning

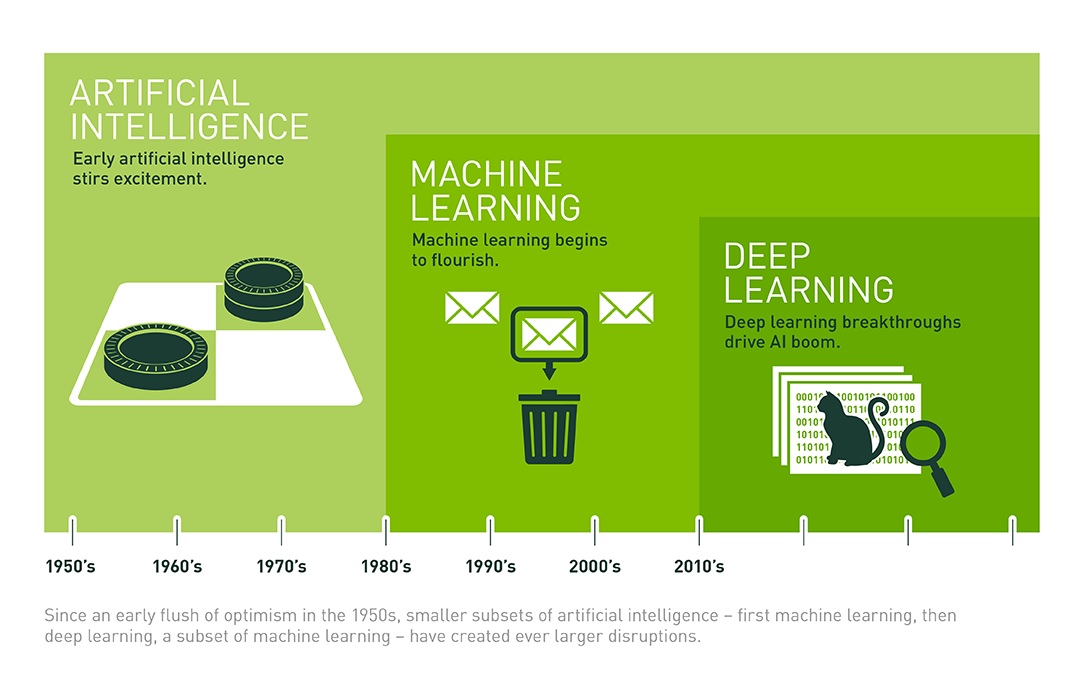

Deep learning là một tập hợp con của AI (Artificial Intelligence) và Machine Learning sử dụng các mạng thần kinh (neural networks) nhân tạo đa lớp để mang lại độ chính xác hiện đại trong các nhiệm vụ như phát hiện đối tượng, nhận dạng giọng nói, dịch ngôn ngữ và các thứ khác.

Deep Learning khác với các kỹ thuật học máy truyền thống ở chỗ chúng có thể tự động học các biểu diễn từ dữ liệu như hình ảnh, video hoặc văn bản mà không cần đưa ra các quy tắc được mã hóa bằng tay hoặc vùng kiến thức của con người. Kiến trúc rất linh hoạt của họ có thể học trực tiếp từ dữ liệu thô và có thể tăng độ chính xác dự đoán của họ khi được cung cấp nhiều dữ liệu hơn.

Deep learning chịu trách nhiệm cho nhiều đột phá gần đây trong AI như AlphaGo của Google DeepMind, xe tự lái, trợ lý giọng nói thông minh và nhiều hơn nữa. Với các Deep Learning framework được tăng tốc GPU của NVIDIA , các nhà nghiên cứu và nhà khoa học dữ liệu có thể tăng tốc đáng kể việc đào tạo học sâu, điều đó có thể mất nhiều ngày và vài tuần chỉ trong vài giờ và vài ngày.

Khi các mô hình đã sẵn sàng để triển khai, các nhà phát triển có thể dựa vào các nền tảng suy luận (inference) tăng tốc GPU cho đám mây, thiết bị nhúng hoặc xe tự lái, để cung cấp hiệu suất cao, suy luận độ trễ thấp cho các mạng thần kinh sâu chuyên sâu tính toán nhất.

Nền tảng của NVIDIA AI dành cho nhà phát triển

Phát triển ứng dụng AI bắt đầu bằng việc đào tạo mạng lưới thần kinh sâu (deep neural networks) với bộ dữ liệu lớn. Các deep learning framework được “GPU tăng tốc” cung cấp sự linh hoạt để thiết kế và huấn luyện các mạng thần kinh sâu (deep neural networks) tùy chỉnh và cung cấp giao diện cho các ngôn ngữ lập trình thường được sử dụng như Python và C/C ++. Mọi deep learning framework chính như TensorFlow, PyTorch và các framework khác, đều đã được tăng tốc bởi GPU và hệ thống thư viện GPU, vì vậy các nhà khoa học và nhà nghiên cứu dữ liệu có thể làm việc hiệu quả trong vài phút mà không cần lập trình GPU.

Đối với các nhà nghiên cứu và nhà phát triển ứng dụng AI, GPU NVIDIA Volta và Turing được cung cấp tensor core (lõi tính toán ma trận của NVIDIA) cho họ một giải pháp tức thời để đào tạo nhanh hơn và hiệu suất deep learning cao hơn. Với việc kích hoạt Tensor cores, các tính toán ma trận chính xác hỗn hợp FP32 và FP16 nhân lên đáng kể tốc độ thông lượng của bạn và giảm thời gian đào tạo AI.

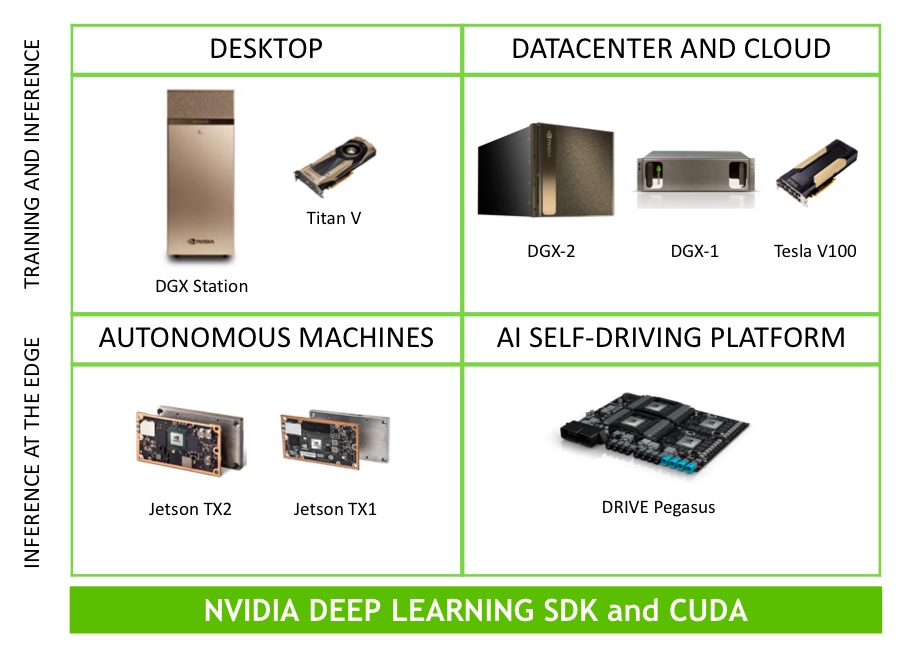

Đối với các nhà phát triển tích hợp mạng thần kinh sâu (deep neural networks) vào ứng dụng nhúng hoặc đám mây, sẽ sử dụng và tích hợp NVIDIA Deep Learning SDK bao gồm các thư viện hiệu suất cao tích hợp các khối API để triển khai đào tạo và suy luận trực tiếp vào ứng dụng của họ. Với một mô hình lập trình duy nhất cho tất cả nền tảng GPU – từ workstation đến data center đến thiết bị nhúng (Intelligence Camera, self-driving car…), các nhà phát triển đầu tiên phát triển ứng dụng AI của họ trên workstation (SuperMicro Workstation), sau đó mở rộng lên cloud (NVIDIA DGX cho AI DC) và triển khai đến các thiết bị biên của họ (Máy chủ suy luận SupperMicro) – với tối thiểu không thay đổi code lập trình.

NVIDIA đã cung cấp các software stack sẵn được tối ưu hóa để tăng tốc các giai đoạn đào tạo và suy luận về quy trình học tập sâu. Nó đã có các container và thiết bị của DGX, Jetson Nano….

Mọi framework AI phổ biến đều được tăng tốc bởi NVIDIA Deep Learning SDK

Deep learning frameworks cung cấp các khối xây dựng để thiết kế, đào tạo và xác nhận mạng lưới thần kinh sâu (deep neural networks), thông qua giao diện lập trình cấp cao. Mọi deep learning frameworks chính như Caffe2, Chainer, Microsoft Cognitive Toolkit, MxNet, PaddlePaddle, Pytorch và TensorFlow đều dựa vào các thư viện NVIDIA Deep Learning SDK để cung cấp đào tạo tăng tốc đa GPU hiệu suất cao. Người dùng framework trên chỉ đơn giản tải xuống khung và trỏ tới và sử dụng GPU để đào tạo.

Nền tảng phát triển hợp nhất – Phát triển để triển khai thực tế.

Các Deep learning framework được tối ưu hóa cho mọi nền tảng GPU từ GPU cho máy để bàn Titan V, RTX (RTX 2080 11G) đến GPU Tesla (NVIDIA Tesla) cấp trung tâm dữ liệu. Điều này cho phép các nhà nghiên cứu và các nhà khoa học dữ liệu bắt đầu quy mô nhỏ và mở rộng khi dữ liệu phình to, số lượng thí nghiệm, mô hình và quy mô nhóm phát triển. Vì các thư viện SDK của Deep Learning tương thích API trên tất cả các nền tảng GPU NVIDIA, khi một mô hình đã sẵn sàng để được tích hợp vào một ứng dụng, các nhà phát triển có thể kiểm tra và xác thực cục bộ trên máy tính để bàn và tối thiểu để không thay đổi mã xác thực và triển khai cho các nền tảng trung tâm dữ liệu của Tesla , Nền tảng nhúng Jetson hoặc nền tảng lái xe tự động. Điều này cải thiện năng suất của nhà phát triển và giảm cơ hội giới thiệu các lỗi khi chuyển từ nguyên mẫu sang sản xuất.

Các nhà phát triển tham gia học viện NVIDIA (NVIDIA Deep Learning Institute) để có đầy đủ các hệ thống thư viện và model cần thiết với dự án AI

Nguồn NVIDIA

Bài viết liên quan

- NVIDIA Omniverse ft Apple Vision Pro: Mở rộng thế giới quan với VR/AR

- Tôi có cần CPU kép không?

- NVIDIA NIM: Vi dịch vụ suy luận tối ưu hóa cho triển khai mô hình AI quy mô lớn

- NVIDIA HGX AI Supercomputer: Nền tảng điện toán AI hàng đầu thế giới

- NVIDIA SuperPOD DGX GB200: Kỷ nguyên của AI nghìn tỷ tham số

- Nền tảng NVIDIA Blackwell: Tạo nên kỷ nguyên điện toán mới