Chi phí môi trường và tài chính ngày càng tăng của Deep Learning đang thu hút sự quan tâm của các doanh nghiệp liên quan. Cùng với đó là các kỹ thuật AI mới như Mạng nơ-ron đồ thị và Học tập đối lập là các xu hướng nổi bật trong thời gian gần đây.

Việc ứng dụng AI đang tăng tốc trên khắp các lĩnh vực, được thúc đẩy bởi sự tổng hợp của kết quả rõ ràng, kỳ vọng cao và cơ hội tạo ra rất nhiều tiền. Trong số các khái niệm và kỹ thuật AI mới ra mắt gần như hàng ngày, 10 xu hướng công nghệ AI đặc biệt thu hút sự chú ý của các nhà khoa học dữ liệu.

1. MLOps

MLOps (Machine learning operations, vận hành hệ thống học máy) không phải là một khái niệm mới, nhưng nó là một loại “Ops” mới xuất hiện gần đây để vận hành các mô hình học máy. MLOps tìm cách hiểu những gì hoạt động và không hoạt động trong một mô hình để tạo ra những mô hình đáng tin cậy hơn trong tương lai.

Lee Rehwinkel, Phó chủ tịch bộ phận khoa học của công ty phần mềm bán hàng và định giá B2B, cho biết đây là bước cuối cùng của quá trình xây dựng mô hình học máy và một thực tiễn mà trước đây không được chú ý nhiều.

“Đó là một trong những lý do khiến nhiều mô hình không bao giờ đạt đến kết quả cuối cùng, nhưng điều đó cực kỳ quan trọng, bởi vì bạn xây dựng một mô hình nhưng làm sao bạn biết được thời gian hoạt động của mô hình đó? Nó sẽ đưa ra dự đoán nhanh đến mức nào? Nó có cần được đào tạo hay tái đào tạo lại hay không? “, ông nói.

2. Học tập đối lập (Contrastive Learning)

Học tập đối lập là một kỹ thuật học máy mà ở đó mục tiêu là tìm những thứ tương tự và khác nhau trong một tập dữ liệu không có nhãn. Ví dụ, nó có thể được sử dụng trên cơ sở dữ liệu hình ảnh để tìm các hình ảnh giống nhau.

Cameron Fen, trưởng nhóm nghiên cứu của AI Capital Management , cho biết: “Học tập đối lập đang trở thành mô hình mới trong học tập không giám sát.

“Thông thường, bạn có thể làm điều này với học chuyển tiếp (Transfer Learning), nhưng điều khiến việc học đối lập trở nên thú vị là bạn có thể làm điều này với dữ liệu quá khó để gắn nhãn và với tập dữ liệu lớn hơn nhiều so với việc tinh chỉnh bộ phân loại hình ảnh dựng sẵn trên ImageNet”, ông nói.

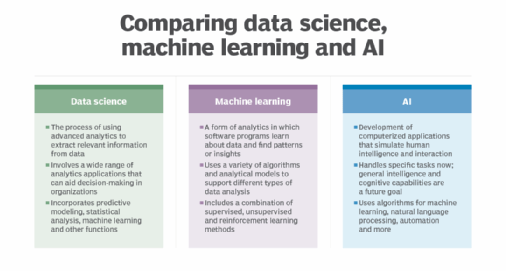

So sánh khoa học dữ liệu, học máy và AI

So sánh khoa học dữ liệu, học máy và AI

3. Bộ chuyển đổi (Transformer)

Transformer là một kiến trúc mạng nơ-ron, giống như mạng nơ-ron tuần hoàn (RNN), xử lý dữ liệu đầu vào tuần tự. Nó được sử dụng rộng rãi trong các mô hình ngôn ngữ, bao gồm các ứng dụng dịch ngôn ngữ và chuyển lời nói thành văn bản.

Được tạo ra bởi các nhà nghiên cứu của Google vào năm 2017, Transformer đã thay thế các mô hình RNN phổ biến, chẳng hạn như thuật toán bộ nhớ ngắn hạn dài (LSTM), được sử dụng trong các ứng dụng xử lý ngôn ngữ tự nhiên.

Fen cho biết: Một Transformer “học cách đặt trọng số cao hơn vào những khoảng thời gian mà nó muốn chú ý đến, tạo ra giá trị trung bình có trọng số của đầu vào để đưa vào mô hình”, Fen nói. “Điều này cho phép mô hình được song song hóa và có bộ nhớ dài hơn (so với các mô hình LSTM).

4. Carbon footprint (dấu chân carbon, tồn dư carbon)

Nhu cầu lưu trữ dữ liệu và tính toán cao hơn đối với các workload AI làm tăng lượng khí thải carbon của một công ty trong thời đại mà nhiều quốc gia đang tham gia Thỏa thuận Paris và các thống đốc bang của Hoa Kỳ đang tham gia Liên minh Khí hậu Hoa Kỳ.

Khi các công ty sử dụng nhiều bộ nhớ và máy tính hơn để tận dụng khả năng học sâu, họ đang tăng lượng khí thải carbon của mình, điều này trực tiếp mâu thuẫn với yêu cầu về “kinh doanh bền vững” (giảm phát thải carbon) của doanh nghiệp.

Ravi Guntur, người đứng đầu bộ phận máy học tại Traceable.ai, cho biết: “Có những cạm bẫy xung quanh chi phí của việc chạy học sâu”, cho biết Ravi Guntur, người đứng đầu bộ phận học máy tại Traceable.ai, cho phép bảo mật API và ứng dụng cho các ứng dụng gốc trên đám mây. “Đại học Massachusetts tại Amherst phát hiện ra rằng việc đào tạo một mô hình học sâu [tạo ra 626.000 pound carbon dioxide làm ấm hành tinh], tương đương với lượng phát thải của năm chiếc ô tô trong suốt cuộc đời của chúng”.

5. Chi phí bằng tiền của việc học sâu

Học máy cũng có chi phí bằng tiền! Nghe có vẻ kỳ lạ nhưng hãy xem ví dụ sau. Bạn hoàn toàn có thể chạy mạng nơ-ron trong cả ngày, chỉ để phát hiện ra một vấn đề rất nhỏ. Sẽ có chi phí cho lưu trữ và xử lý dữ liệu, và có thể là thêm thời gian lãng phí của nhà khoa học dữ liệu dành cho việc chờ đợi kết quả.

Guntur nói: “Chi phí của việc học máy đang ảnh hưởng đến các học viên. Chúng tôi liên tục suy nghĩ về việc liệu chúng tôi cần cụm máy tính này hay cụm kia, hay GPU nào. Vì vậy, câu hỏi đặt ra cho nhóm kỹ thuật là, liệu có một thuật toán thay thế nào mà chúng tôi có thể sử dụng để chúng tôi không phải trả trước cho các CPU và GPU mà chúng tôi muốn? Tại sao bạn không thể xây dựng một thuật toán hiệu quả hơn?”

6. Đồ thị (Graphs)

Đồ thị là tất cả những gì về các mối quan hệ. Được tạo thành từ các nút/node – đại diện cho một chủ thể, chẳng hạn như người, đối tượng hoặc địa điểm – và các cạnh – đại diện cho các mối quan hệ giữa các nút – đồ thị có thể nắm bắt các mối quan hệ phức tạp.

Mạng nơ-ron đồ thị (GNN) là một loại kiến trúc mạng nơ-ron có thể giúp hiểu các biểu đồ, cho phép mọi người đưa ra các dự đoán về nút hoặc cạnh. Ví dụ: bằng cách sử dụng GNN, ai đó có thể dự đoán thể loại phim mà diễn viên sẽ đóng vai chính hoặc tác dụng phụ của một loại thuốc mới có thể bất hợp pháp.

Guntur cho biết: “Những loại biểu đồ này ngày càng trở nên phổ biến hơn bởi vì nó là thông tin phong phú. Ông nói thêm, thật khó để làm việc với các biểu đồ do chúng chứa bao nhiêu thông tin.

7. Bộ công cụ tích hợp dễ sử dụng hơn

Các nhà khoa học dữ liệu và các lãnh đạo nhóm của họ theo truyền thống buộc phải kết hợp với nhau các công cụ để xây dựng, thử nghiệm, đào tạo và triển khai. Tuy nhiên, trong những năm gần đây, các nhà cung cấp công nghệ tên tuổi đã có được khả năng hoàn thiện các dịch vụ của họ để họ có thể trở thành một cửa hàng tổng hợp.

Điều này cho phép các nhà khoa học dữ liệu sử dụng một nền tảng duy nhất, thay vì nhiều nền tảng và công cụ, để làm việc, loại bỏ các vấn đề phát sinh từ việc vận chuyển dữ liệu và mô hình giữa các công cụ. Nhiều nền tảng trong số này cũng có các ứng dụng ít mã hoặc không có mã, có nghĩa là chúng nhanh hơn và dễ dàng hơn cho các nhà khoa học dữ liệu sử dụng.

Rehwinkel nói: “Tôi có thể xây dựng một mô hình dự đoán rất tốt mà không nhất thiết phải nhúng tay quá sâu vào bất kỳ đoạn mã nào. Nó thực sự giúp tôi tăng tốc khả năng giải quyết vấn đề của mình.”

8. Mô hình giải thích mô hình khác

Vào năm 2020, có một sự cải tiến lớn trong các quy định về AI và nỗ lực để soạn thảo thêm các quy định về AI. Đáng chú ý là các hướng dẫn do Ủy ban Thương mại Liên bang Hoa Kỳ ban hành về “sự thật, công bằng và bình đẳng” trong AI, đưa ra cảnh báo cho các công ty sử dụng các thuật toán thiên vị. Ủy ban Châu Âu cũng đưa ra một đề xuất về quy định của AI, bao gồm các khoản tiền phạt nặng do không tuân thủ.

Khi quy định gia tăng, nhiều nhà cung cấp AI phát hành các mô hình AI có thể giúp giải thích các mô hình khác, giúp các doanh nghiệp dễ dàng thấy lý do cơ bản khiến các mô hình của họ đưa ra những dự đoán nhất định.

Josh Poduska, trưởng nhóm khoa học dữ liệu tại Domino Data Lab cho biết: “Chúng tôi sẽ sớm sử dụng các mô hình để giải thích các mô hình. Khả năng diễn giải, giải thích và kiểm tra các mô hình học máy và học sâu đang trở nên quan trọng do áp lực quy định tăng cường này và nhu cầu đó có thể giải thích các góc độ Why và How của các dự đoán, chứ không chỉ có What”.

Vì một số hệ thống AI đang tự động hóa các quyết định, điều này tạo ra “sự công bằng như mã” (Equity-as-code), Chris Bergh, Giám đốc điều hành và người sáng lập của nhà cung cấp nền tảng DataOps DataKitchen cho biết.

Bergh cho biết: “Các nhà khoa học dữ liệu và các bên liên quan trong kinh doanh trước tiên phải làm việc cùng nhau để phát triển các số liệu dành riêng cho ứng dụng để kiểm tra độ chệch. Equity-as-code có thể được chạy theo yêu cầu để phát hiện sự thiên vị và đảm bảo rằng nó không được triển khai.”

9. Nhúng các từ được ngữ cảnh hóa

Nhúng từ tĩnh đại diện cho các từ dưới dạng thực thể toán học (ví dụ: vectơ trong không gian vectơ), cho phép sử dụng toán học để phân tích mối liên quan ngữ nghĩa của các từ bằng những điểm tương đồng của cách nhúng của chúng. Ví dụ: “quả táo” gần với “quả chanh” hơn “ngôi nhà”.

Silke Dodel, kiến trúc sư học máy tại nhà cung cấp giải pháp dịch hội thoại Language I/O cho biết: “Một trong những xu hướng có ảnh hưởng nhất là chuyển từ nhúng từ tĩnh như word2vec và GloVe sang nhúng từ theo ngữ cảnh như ELMo và BERT”.

Bên cạnh các nhân vật trong Sesame Street, BERT và ELMo là các mô hình ngôn ngữ giúp giảm thời gian đào tạo và tăng hiệu suất của các mô hình hiện đại.

Cô nói: “Việc nhúng từ theo ngữ cảnh giải quyết vấn đề về sự phụ thuộc ngữ nghĩa của một từ vào ngữ cảnh của nó, chẳng hạn như ‘ngân hàng’ trong ngữ cảnh của ‘công viên’ có nghĩa khác với ‘ngân hàng’ trong ngữ cảnh ‘tiền bạc'”.

10. Dữ liệu nhỏ

Trong thời đại dữ liệu lớn ngày nay, có một quan niệm sai lầm chung rằng dữ liệu lớn là cần thiết để hiểu bất cứ điều gì. Tuy nhiên, dữ liệu nhỏ cũng có giá trị riêng của nó.

Dữ liệu nhỏ là dữ liệu đủ nhỏ để mọi người có thể hiểu được, chẳng hạn như mã bưu chính của Hoa Kỳ.

“Khi bạn đang xử lý dữ liệu nhỏ, bạn cần quay lại một số khái niệm cũ trong học máy và nhà khoa học dữ liệu. Bạn cần đọc lại một số bài báo cũ để giải quyết một số vấn đề về dữ liệu nhỏ và dữ liệu độc quyền”, Guntur nói . “Xử lý dữ liệu nhỏ và đưa ra các thuật toán cho dữ liệu nhỏ rất khác so với xu hướng hiện tại khi mọi người cố gắng sử dụng mạng nơ-ron hoặc tất cả các biến thể của học sâu”.

Bài viết liên quan

- Máy chủ Supermicro X14: Hiệu suất mạnh mẽ, hiệu quả tối đa cho AI, Cloud, Storage, 5G/Edge

- Tôi có cần CPU kép không?

- NVIDIA HGX AI Supercomputer: Nền tảng điện toán AI hàng đầu thế giới

- NVIDIA SuperPOD DGX GB200: Kỷ nguyên của AI nghìn tỷ tham số

- Nền tảng NVIDIA Blackwell: Tạo nên kỷ nguyên điện toán mới

- NVIDIA DGX B200: Nền tảng AI thống nhất cho Training, Fine-tuning và Inference AI